Cadeira de rodas é controlada por movimentos da face e da íris

Pesquisadores da Unicamp (Universidade Estadual de Campinas) desenvolveram uma cadeira de rodas que pode ser controlada por pequenos movimentos da face, da cabeça ou da íris.

O equipamento ainda é considerado experimental e de alto custo. Porém, um projeto aprovado recentemente pela Fapesp (Fundação de Amparo à Pesquisa do Estado de São Paulo), tem como objetivo adaptar a tecnologia para torná-la mais acessível e colocá-la no mercado brasileiro dentro de dois anos.

A tecnologia desenvolvida por pesquisadores da Faculdade de Engenharia Elétrica e de Computação poderá beneficiar pessoas com tetraplegia, vítimas de acidente vascular cerebral (AVC), portadores de esclerose lateral amiotrófica ou outras condições de saúde que impedem o movimento preciso das mãos.

- A luz solar pode melhorar a qualidade do seu sono? Pois é, pode! Entenda o que acontece com seu corpo

- 72h em Chicago: roteiro com passeios e gastronomia acessível

- Não fazer isso na hora de dormir eleva risco de pressão alta

- Como melhorar a memória com exercícios simples e naturais

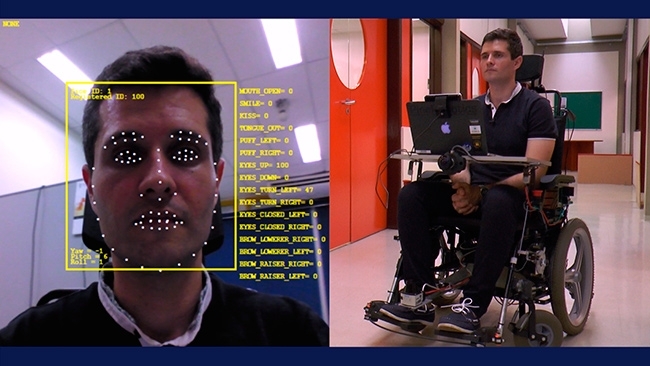

O protótipo é equipado com diversos dispositivos normalmente encontrados em robôs, como sensores capazes de medir a distância de paredes e de outros objetos ou detectar diferenças de profundidade no piso, um notebook que envia os comandos diretamente para a cadeira e com uma câmera 3D com a tecnologia RealSense que permite interagir com o computador por meio de expressões faciais ou movimentos corporais.

De acordo com os pesquisadores, a câmera identifica mais de 70 pontos da face –em torno da boca, do nariz e dos olhos– e, a partir da movimentação desses pontos, é possível extrair comandos simples, como ir para frente, para trás, para a esquerda ou direita e, o mais importante, parar.

Também é possível interagir com o computador por meio de comandos de voz, mas essa tecnologia é considerada menos confiável que as expressões faciais por causa das diferenças de timbre e da possível interferência de ruído ambiente.

O protótipo do sistema, batizado de Wheelie, deverá estar pronto até o início de 2017. Dois desafios deverão ser vencidos nesse período: melhorar a classificação das expressões faciais, de modo a evitar que a interpretação dos sinais fique prejudicada por diferenças na iluminação ambiente, e garantir que apenas as expressões faciais do usuário da cadeira sejam capturadas quando houver outras pessoas próximas.

Com informações da Agência Fapesp